Fluctuations

« Nos espérances scientifiques

nous ont conduit chacun aux

antipodes de l’autre.

Tu crois au Dieu qui joue aux dés et moi à la seule

valeur des lois dans un univers où quelque

chose existe objectivement, que je cherche

à saisir d’une manière sauvagement spéculative. »

Einstein – Extrait d’une lettre à Max Born de 1944.

« Fluctuat nec mergitur »

Devise de la ville de Paris

Einstein et les fluctuations

(Fluctuations : évolutions spontanées incessantes, aléatoires, des systèmes physiques au voisinage de leur état d’équilibre)

Dans l’extrait de lettre cité plus haut, les médias, toujours déformants ont traduit par « Dieu ne joue pas aux dés », or Einstein est loin d’être aussi péremptoire. Il met en balance les probabilités, fondamentales en physique subatomique, et la certitude apparente des lois. Einstein pense que tout peut être expliqué en termes de lois et que les probabilités appliquées au monde physique ne sont pas suffisantes pour l’esprit humain qui refuse le hasard. La raison doit pouvoir triompher. C’est un monde parfaitement déterministe, celui de Spinoza, auquel Einstein adhère totalement. Tout à une cause selon le principe de raison suffisante de Leibniz. C’est la thèse laplacienne où tous les évènements doivent pouvoir s’imbriquer les uns les autres, par l’espace et le temps, dans un enchaînement causal. On pourrait ainsi concevoir un monde ordonnancé, généré par un principe originel. Einstein était pénétré par cette idée que la science doit pouvoir tout expliquer. Il passa les dernières années de sa vie a essayer, en vain, d’unifier l’électromagnétisme et la gravitation pour mieux accéder à cette ultime explication des ressorts de la nature. On peut comprendre sa volonté d’aller vers ce qui lui paraissait être la vérité.

On ne peut absolument en déduire qu’Einstein était opposé à introduire le calcul des probabilités dans la science physique. Vers 1902-1904 il lut avec beaucoup d’intérêt les « Leçons sur la théorie des gaz » de Ludwig Boltzmann. Ce dernier décrit l’état d’un gaz par l’entropie S, sans connaître les états (vitesse et position) de chacune des molécules de ce gaz. L’équilibre thermique (la température et la pression) est obtenu par la distribution la plus probable de ces états. Les molécules du gaz dans une enceinte ont une configuration (positions et vitesses) qui se répartit autour d’une moyenne qui concrétise la température. On associe une probabilité (w) à chaque configuration possible des molécules. L’entropie S est proportionnelle au logarithme de cette probabilité autrement dit S=k log W (k étant une constante dénommée constante de Boltzmann). Un état d’énergie du gaz correspond à un ensemble de complexions élémentaires ou répartition de molécules pensées comme individuellement marquées ou discernables dans chaque intervalle ou cellule de vitesse d’égale probabilité. Boltzmann calcule la probabilité en faisant le décompte des permutations des molécules d’une même cellule.

Einstein voyait là un « principe général de la nature ». Il demande simplement d’interpréter la probabilité non sous forme combinatoire, trop arbitraire selon lui, mais sous forme physique en voyant dans cette probabilité dans le temps des états possibles du système. En effet Boltzmann doit faire l’hypothèse que toutes les configurations ont la même probabilité de se produire. Il doit aussi admettre que tous les états microscopiques sont accessibles (hypothèse ergodique). Einstein publie en 1903 un article intitulé « Une théorie des fondements de la thermodynamique ». Il s’aperçoit que k exprime la stabilité thermique d’un système à travers ses fluctuations d’énergie. Il veut approfondir l’idée des fluctuations aléatoires autour d’une moyenne. Cette idée de fluctuations peut aussi bien se rapporter aux molécules qu’au rayonnement thermique enclos dans un espace fini, le corps noir.

Le mouvement brownien permet la vérification de ces fluctuations. L’article d’Einstein paraît en 1905, dans la revue « Annalen der Physik », intitulé « Sur le mouvement des particules en suspension dans un fluide au repos impliqué par la théorie cinétique moléculaire de la chaleur ». Le mouvement brownien est obtenu par une particule dans un fluide qui est soumis aux chocs des molécules du fluide. Les vitesses de ces molécules sont réparties autour d’une vitesse moyenne selon une courbe en cloche dont la forme dépend de la température. Cette agitation thermique dans le fluide produit une force fluctuante sur la particule. L’effort cumulé de tous ces chocs s’oppose au mouvement de la particule quand celle-ci a une vitesse moyenne par rapport au fluide. La force fluctuante due aux chocs tend à augmenter la température de la particule tandis que le deuxième effet de dissipation tend à ramener à zéro sa vitesse moyenne par rapport au fluide et donc à diminuer la température de la particule. Les deux effets conduisent à un équilibre où la température de la particule proportionnelle à son énergie cinétique, est juste égale à la température où elle baigne. Einstein montre que lorsque cet équilibre est établi, il existe une relation entre la diffusion de la particule et les caractéristiques du milieu, telles que sa température et sa viscosité.

Comme il est possible d’obtenir le déplacement moyen des particules en suspension et les fluctuations autour de cette valeur, il est possible d’en déduire des grandeurs physiques comme la constante de Boltzmann k, le nombre d’Avogadro ou le libre parcours moyen des molécules entre deux chocs. Einstein démontre ainsi l’existence des atomes en utilisant les probabilités comme fréquence d’évènements ou d’états et en utilisant les fluctuations de ces fréquences autour de leur valeur moyenne.

L’article d’Einstein de 1905 sur l’effet photoélectrique a pour argument essentiel les fluctuations de la lumière. La loi de Planck telle que formulée aujourd’hui associe un nombre entier de quanta de lumière (photons) à tout mode du champ électromagnétique. Elle donne la valeur moyenne de ce nombre pour une fréquence du rayonnement et une température donnée. Pour obtenir cela, Planck utilise une loi énoncée par Boltzmann qui relie l’entropie d’un système au nombre de configurations possibles du système S=k log W.

Einstein démontre que la nouvelle façon de compter les configurations correspond à une lumière constituée de quanta c’est-à-dire de particules, véhiculant chacune une énergie qui est proportionnelle d’une part, à la constante de Planck, et d’autre part, à la fréquence de la lumière.

Un rayonnement peut être assimilé à un gaz car il exerce aussi une pression sur une paroi. Il se comporte comme s’il était composé de points matériels, les quantas de lumière d’énergie proportionnelle à sa fréquence. Einstein écrit : « Il faut cependant garder à l’esprit que les observations optiques concernant des moyennes dans le temps et non pas des valeurs instantanées et qu’en dépit de la parfaite confirmation par l’expérience, on conçoit parfaitement que la théorie de la lumière opérant avec des fonctions continues de l’espace conduise à des contradictions avec l’expérience quand on l’applique aux phénomènes de production et de transformation de la lumière. Selon l’hypothèse à retenir ici, lors de la propagation d’un rayon lumineux à partir d’un point, l’énergie n’est pas distribuée dans des espaces de plus en plus grands, mais elle est constituée d’un nombre infini de quanta d’énergie localisés en des points de l’espace qui se déplacent sans se dissocier et qui ne peuvent être absorbés et produits que d’un coup ».

Un corps noir est une cavité fermée, chauffée, en état d’équilibre thermique entre le rayonnement émis et celui absorbé par les électrons du milieu, considérés comme des résonateurs. Planck avait admis que les énergies de rayonnement échangées avec les électrons résonateurs étaient discontinues, proportionnelles aux fréquences selon E= n h √. Une énergie qui résonne dans un atome à un certain niveau ne pourra résonner qu’à un autre niveau avec un saut quantique proportionnel à la fréquence.

Le rayonnement thermique se comporte du point de vue de la dynamique statique comme s’il était constitué de points matériels, les quantas de lumière. Il faut donc admettre que l’énergie de la lumière est distribuée de façon discontinue dans l’espace par ces quanta. Planck quantifiait les échanges d’énergies entre matière et rayonnement. Einstein va plus loin en quantifiant l’énergie de rayonnement lui-même.

En 1907 Einstein propose que la loi de Planck décrive l’état d’équilibre thermodynamique des vibrations dans les matériaux.

En 1909, revenant au problème de la lumière Einstein calcule les fluctuations de l’énergie lumineuse se trouvant dans une région délimitée de l’espace. Il démontre que les fluctuations sont obtenues en ajoutant deux contributions qui correspondent respectivement, à une interprétation ondulatoire et à une interprétation corpusculaire de la lumière. Il met ainsi en évidence pour la première fois la dualité onde-corpuscule sur des résultats les plus profonds de la théorie quantique.

En 1917, Einstein écrit un article qui contient la découverte de l’émission stimulée (laser). Il s’agit à nouveau d’une application remarquable des méthodes statistiques de Maxwell et Boltzmann à la théorie de la lumière. Il décrit les processus élémentaires d’émission et d’absorption qui sont associés à des transitions entre les niveaux atomiques dont l’existence vient d’être postulée par Niels Bohr. Les processus d’absorption ne peuvent exister qu’en présence de quanta de lumière, les processus d’émission peuvent se produire quand même en leur absence. Il y a en effet deux types de processus d’émission, les processus stimulés par la présence de quanta de lumière et les processus spontanés qui peuvent se produire même dans le vide. Ceci conduit à la première interprétation complètement satisfaisante de la loi de Planck qui découle maintenant de l’équilibre cinétique entre les différents processus d’émission et d’absorption ou ce qui revient au même, au bilan des différentes transitions de l’atome entre ses niveaux.

Einstein étudie les bilans de transfert d’impulsion (ou quantité de mouvement) entre l’atome et la lumière et pas seulement les bilans de transfert d’énergie. Il montre alors que chaque processus élémentaire d’admission et d’absorption est accompagné d’une variation précise de l’impulsion de l’atome. Cela ne peut se comprendre que parce que les quanta de lumière transportent non seulement une énergie, mais une impulsion dirigée selon la direction de propagation de la lumière. Les lois de conservation imposent donc une variation de l’énergie et de l’impulsion de l’atome lorsqu’un photon est émis ou absorbé. C’est dans cet article de 1917 que le quantum de lumière désigné plus tard par photon se trouve pour la première fois pourvu de tous ses attributs de particule à savoir son énergie et son impulsion.

Dans l’absorption, un photon est absorbé par l’atome qui passe de son énergie la plus basse vers un état d’énergie plus élevée. La probabilité d’un tel processus est proportionnelle à la population en électrons de niveau de départ et au nombre des photons incidents. Dans un processus d’émission, un photon est émis et l’atome passe de son énergie la plus élevée vers un état d’énergie plus basse. La probabilité d’un tel processus est proportionnelle à la population du niveau de départ et les processus stimulés, c’est-à-dire ceux déclenchés par la présence de photons incidents. Elle est de plus proportionnelle au nombre de photons incidents. Pour les processus spontanés qui peuvent se produire même dans le vide, la probabilité ne dépend pas de ce nombre.

A très basse température les atomes d’un gaz parfait se regroupent dans le même état. Ils gèlent en quelque sorte et ne font plus qu’un. Les particules matérielles massiques identiques n’interagissent plus. C’est un état d’énergie minimale.

Bose, physicien indien, avait adressé à Einstein un article où, considérant le rayonnement électromagnétique comme un gaz de photons, il retrouvait la loi de Planck qui donne la répartition en fréquence de l’énergie du rayonnement électromagnétique d’un corps noir, une enceinte en équilibre thermique percée d’un petit trou. Einstein applique aux gaz parfaits, cette méthode étudiée dans le cas d’un gaz de photons, de particules sans masse associées aux ondes électromagnétiques, le comportement d’un gaz parfait étant celui de particules matérielles identiques. Ceci donne naissance à la physique statistique quantique. Les phénomènes issus de la loi des grands nombres sont visibles à l’œil nu.

Dans le cas d’un gaz de photons à l’équilibre thermique dans une enceinte, on appelle un mode, le nombre moyen de photons occupant un état d’énergie bien définie. Ceci fait intervenir la température et l’énergie du mode et s’applique aux bosons.

Einstein considère le cas simple d’un gaz parfait enfermé dans une enceinte. Les ondes associées à la matière peuvent se trouver dans divers modes ou états d’énergies bien définis. Le mode d’énergie minimale est le mode fondamental où les particules ont une vitesse nulle. Les autres modes sont dits excités. Il y a une valeur maximale pour le nombre moyen de particules dans les modes excités. Les atomes se rassemblent brusquement dans l’état d’énergie minimale créant une zone de densité élevée ou les atomes sont piégés comme dans un puits. C’est une transition de phase.

A une onde correspond une particule et Bose utilise cela pour calculer le nombre moyen de photons à l’équilibre thermique dans une enceinte. Son résultat fait intervenir la température et l’énergie du mode. Les particules qui sont dans le mode d’énergie minimale ont une vitesse nulle. Les autres modes sont dits excités et les particules y ont une vitesse et donc une énergie cinétique nulles. Ces modes excités sont peuplés par un nombre limité de particules.

Les six paramètres d’un quantum de lumière : position et vecteur de quantité mouvement caractérisent un espace de phases à six dimensions. Lorsque la température chute vers le 0° absolu, un nombre de molécules continument croissant avec la densité s’installe dans le premier état quantique qui est l’état d’énergie fondamental. C’est la dégénérescence du gaz. L’indépendance statistique des particules est perdue. Elles s’étagent dans les niveaux de l’atome en nombre limité.

Dans cet article de 1916, Einstein propose une théorie pour l’échange de rayonnement et de matière.

Il y a trois processus d’échange :

1 – absorption. L’atome passe à un état d’énergie supérieure.

2 – émission stimulée. L’atome stimulé par un photon incident passe à un niveau d’énergie inférieure en émettant un photon.

3 – émission spontanée. L’atome passe spontanément à un niveau d’énergie inférieur en émettant un photon. Cet évènement d’après Einstein n’a pas de cause spécifique. On ne peut lui attribuer qu’une probabilité d’avoir lieu. Ceci montre qu’Einstein admet parfaitement le pur hasard.

Jacobus Van’t Hoff avait trouvé une analogie entre la pression osmotique et celle d’un gaz parfait.

Les molécules diluées dans un solvant se comportent comme les molécules d’un gaz parfait.

Pour Einstein ce qui est vrai pour les solutions l’est également pour les suspensions diluées. Cela va permettre de déterminer le nombre d’Avogadro.

Dans les articles qui paraissent entre 1902 et 1904 il expose sa version de la mécanique statistique. Son attention est attirée par les fluctuations dans un système en équilibre. Si les irrégularités des grands systèmes disparaissent en moyenne en raison du grand nombre de molécules qui les composent, les fluctuations créent de nets écarts par rapport aux valeurs thermodynamiques moyennes dans des systèmes contenant un nombre plus faible de particules (c’est-à-dire tout de même plusieurs milliers, voire des millions de particules). Ces fluctuations ne sont guère possibles à mettre en évidence dans un système de taille macroscopique et dans des conditions normales. Einstein cherche des situations où l’on puisse les détecter de façon à obtenir la constante de Boltzmann K et le nombre d’Avogadro N. Le nombre de molécules de gaz n est égal à n moles x N. On a suivant la loi des gaz parfaits PV = nkT = RT. R est mesuré. La détermination de k peut donner N. Einstein pense que le corps noir est un système physique qui révèlera les fluctuations.

Pour illustrer ces différentes statistiques, celle des bosons et celles des fermions, imaginons cinq casiers et cinq particules.

Si les cinq particules sont discernables ce qui est le cas des fermions, qui s’excluent les uns les autres, il y a 5x4x3x2x1 = 120 manières de les répartir dans les cinq casiers. La disposition d’une particule par casier est plus probable que cinq particules dans un même casier.

Si les cinq particules sont indiscernables ce qui est le cas des bosons dont les photons font partie, il y a cinq possibilités de mettre cinq particules dans cinq casiers. C’est la première possibilité qui est la plus probable. Les particules ont donc tendance à se coller entre elles dans le même casier par effet statistique. Les particules discernables suivent le principe d’exclusion de Pauli et s’étagent sur les différents niveaux suivant leur nombre maximum par niveau. L’effet statistique est dit de Bose-Einstein pour les bosons et de Fermi-Dirac pour les fermions. Dans un premier cas on réunit et dans le deuxième on disperse.

Les fluctuations autour d’une moyenne sont des phénomènes dualistes car il s’agit d’alternances. Pour un physicien, la fluctuation est un écart aléatoire par rapport à une moyenne, une hétérogénéité par rapport à une situation homogène. Par exemple ce sont les hétérogénéités de l’air en l’occurrence les molécules d’azotes et d’oxygène qui le constituent, qui rendent le ciel bleu.

On voit ainsi par cette étude qu’Einstein était loin de s’opposer aux probabilités donc en fait, au hasard. Bien au contraire, il y voyait un principe général de la nature. Le problème de qualifier les lois de la nature de probabilitaires conduit à douter de la certitude de ces lois. Comme les objets sont des groupements d’atomes, on ne peut que convenir que la probabilité régnant dans le domaine subatomique, on ne voit pas pourquoi on pourrait conclure à une certitude des lois macroscopiques. Il faudrait simplement admettre que les fluctuations qui ont lieu indubitablement aux échelles microscopiques se lissent aux grandes échelles. Vu leur grand nombre les fluctuations finissent à la longue par se compenser et on a ainsi l’impression que tout s’écoule de manière uniforme. Mais cela n’est jamais qu’une illusion. On sait que l’énergie ne peut se mesurer que par grains. En est-il de même pour l’espace et le temps ? Jusqu’à maintenant on n’a pas pu s’en rendre compte, mais cela est dans doute dû au fait que cela peut se produire à des échelles voisines de celles de Planck. Nos appareils ne nous permettent pas, pour le moment, d’observer à ce niveau. Le vide quantique est probablement le foyer de cette agitation fluctuante. Ces fluctuations du point zéro naissent des relations d’indétermination de Heisenberg. Pour des grandeurs conjuguées comme l’énergie et le temps (l’un ne va pas sans l’autre, c’est dualiste) on ne pourrait obtenir une valeur zéro pour l’un sans que la valeur de l’autre soit infinie. Ceci signifie que leur produit, c’est-à-dire l’action, ne peut être supérieur à h, la constante de Planck qui caractérise ces mesures.

Il faut donc admettre maintenant que ce que l’on pourrait considérer comme la plus certaine des lois possède en elle un fondement fluctuant aléatoirement, même si cela n’est pas détectable. On ne peut évidement pas dire quelle serait la réaction d’Einstein si l’on avait réussi à lui faire admettre que les lois sont probabilistes, lois pour lesquelles il avait la plus juste admiration en pensant qu’un Dieu immanent à la nature était à l’origine de tout cela.

C’est sans doute la raison pour laquelle, il en vint à critiquer vivement la nouvelle physique, celle dite de Copenhague représentée par Niels Bohr.

Dans cette théorie, il faut accepter qu’une particule soit à la fois ici et là ou qu’une porte soit à la fois ouverte ou fermée.

Lorsque deux particules interagissent, leurs propriétés se couplent et restent corrélées même après que l’action soit terminée. En mesurant une grandeur physique de l’une des particules couplées ou « intriquées » on connait automatiquement la grandeur physique correspondante de l’autre particule.

Une paire d’objets préparés dans un état quantique dit « intriqués » se comporte comme un système unique même si les deux objets sont très éloignés l’un de l’autre. Leur comportement est indifférent à l’espace –temps qui les sépare.

En 1935, Einstein publie un article avec Podolsky et Rosen (surnommé depuis le paradoxe EPR) prétendant que le formalisme quantique que prédisent de très fortes corrélations entre deux particules intriquées, quelle que soit la distance qui les sépare, est incomplet.

Si le faisceau lumineux passe à travers un polariseur, les photons qui traversent le polariseur sont polarisés dans la direction du polariseur (+1) ou dans une direction perpendiculaire (-1). Il n’y a pas d’autres résultats possibles. Un photon incident émerge soit selon la voie +1 soit selon la voie -1. La traversée du polariseur détermine l’état de polarisation de photon.

Pour une paire de photons intriqués, émis simultanément vers la gauche et vers la droite, passant dans deux polariseurs orientés suivant des directions identiques, les résultats seront totalement corrélés. Si l’on a le résultat +1 pour un des photons on obtient avec certitude +1 pour l’autre.

Si les photons lors de la polarisation sont très éloignés l’un de l’autre, on ne peut admettre qu’ils avaient échangé un signal à une vitesse supérieure à celle de la lumière.

La polarisation de chacun des photons intriqués n’est pas déterminée avant la mesure.

Cette expérience montre pour EPR que la mécanique quantique est incomplète. Il y a des paramètres cachés encore inconnus qu’il faut découvrir.

En 1964, John Bell démontre que pour deux particules intriquées les prédictions quantiques sont incompatibles avec tout modèle intégrant de façon explicite des paramètres supplémentaires qui détermineraient la polarisation initiale de chacun des deux photons dès leur émission. Il n’est pas possible pour l’ensemble des orientations possibles des deux polariseurs de reproduire les valeurs des corrélations prédites par la mécanique quantique. Ceci est démontré par l’expérience faites en 1982 par Alain Aspect et ses collaborateurs. Il faut donc renoncer à concevoir le monde comme formé de sous-systèmes séparés, aux propriétés physiques définies localement et à une vision, réaliste, locale du monde que défendait Einstein.

Einstein se serait satisfait d’un monde sans probabilités avec des lois certaines. Quoi qu’il en soit, il a fort bien compris qu’il ne pouvait y avoir aucune certitude. Cet épisode du paradoxe a permis de bien vérifier expérimentalement que le calcul des probabilités régnait en physique atomique.

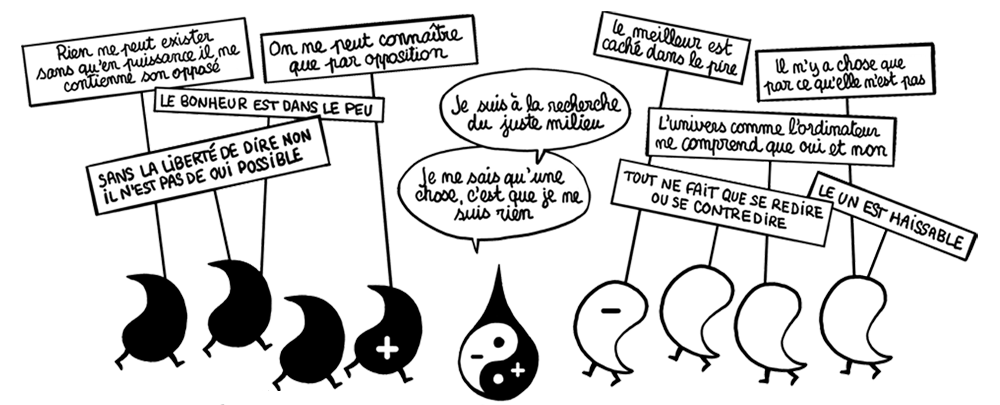

Comme on l’a constaté, Einstein s’est beaucoup préoccupé du problème des fluctuations à petite échelle et sur de petites quantités. Son travail nous intéresse en ce sens que matière et rayonnement sont fluctuants c’est-à-dire oscillent autour d’une valeur moyenne. Einstein reconnaît implicitement ainsi la notion de dualisme moderne que nous désirons développer. Ou les fluctuations s’additionnent et cela peut aboutir à une brusque transition, une catastrophe, ou les fluctuations finissent par leur grand nombre par se compenser. Dans le dernier cas, la valeur de la grandeur mesurée s’aplatit petit à petit autour d’une moyenne, lisse et sans vie. Le monde dans lequel nous vivons est le résultat de fluctuations qui sont la caractéristique de l’existant.

Einstein